アップルの研究者は、AIモデルを用いて非常に暗い環境で撮影された写真を大幅に改善する技術を開発したと発表しました。この技術は、カメラの画像処理パイプラインに拡散モデルを直接統合し、通常失われるセンサーの生データから詳細を復元するものです。

暗所での写真撮影において、画像センサーが十分な光を捉えられない場合、画像が粒子状のデジタルノイズで満たされることがあります。これに対処するため、企業は画像処理アルゴリズムを適用していますが、これが過度に滑らかで油絵のような効果を生み出すと批判されています。

この問題に対処するため、アップルとパデュー大学の研究者は「DarkDiff」と呼ばれるモデルを開発しました。このモデルは、カメラの画像信号プロセッサ(ISP)に拡散モデルを再利用することで、低照度の生画像を強化する新しいフレームワークを提供します。実験では、3つの困難な低照度生画像ベンチマークにおいて、最先端の手法を上回る知覚品質を示しました。

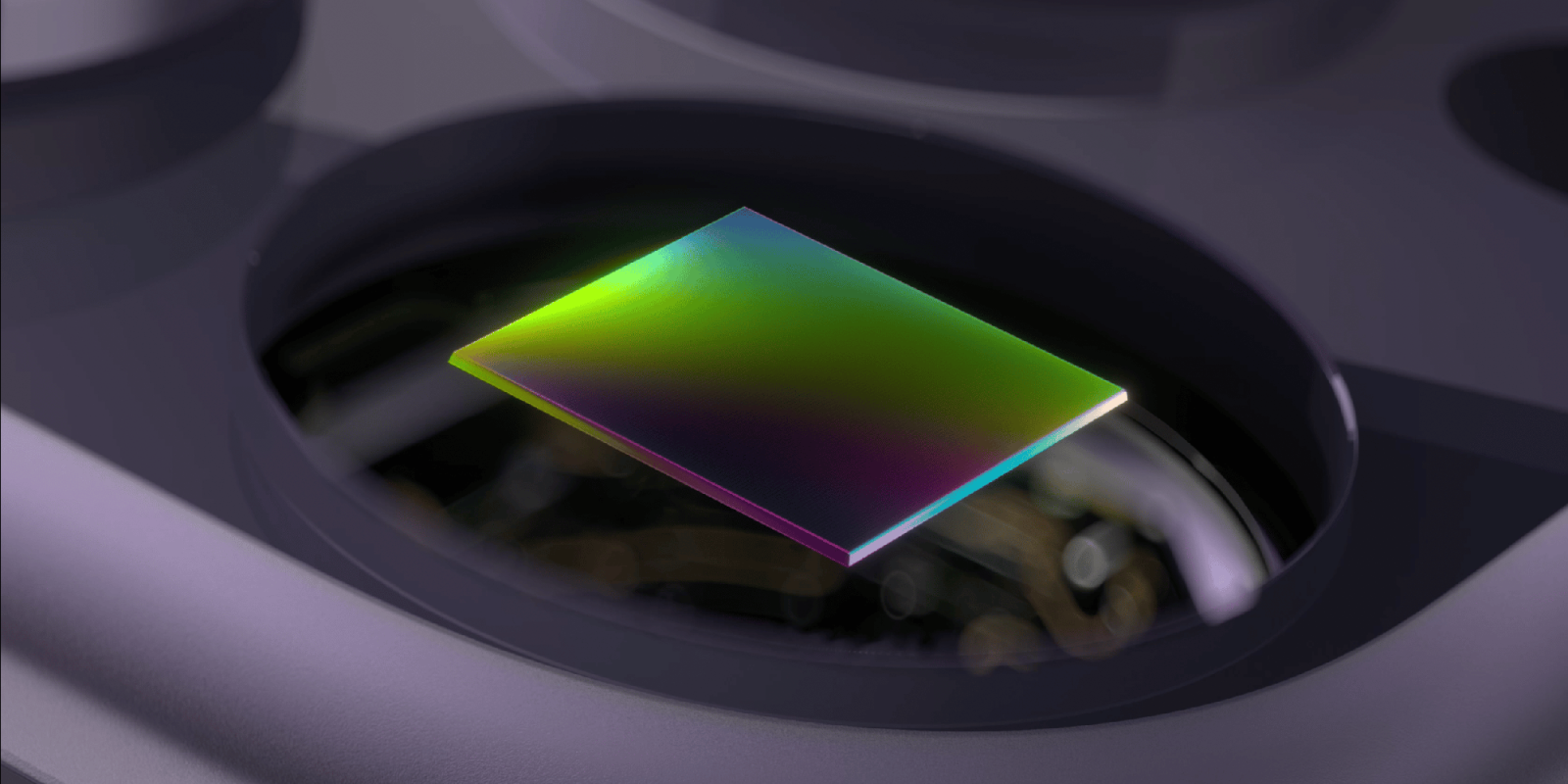

この手法では、AIを後処理段階で適用するのではなく、事前に学習された生成拡散モデルをカメラの画像信号処理パイプラインに統合します。これにより、暗所の写真における詳細を理解し、保存することが可能になります。

また、このアプローチでは、ローカライズされた画像パッチに対する注意を計算するメカニズムを導入し、局所構造を保持しながら不自然な変化を軽減します。DarkDiffは、標準的な拡散技術である分類器フリーガイダンスを使用し、入力画像と学習済みの視覚的先行情報のどちらを重視するかを調整します。

研究者たちは、ソニーA7SIIなどのカメラで非常に低照度の写真を撮影し、他の生画像強化モデルや拡散ベースラインと比較しました。テスト画像は夜間に0.033秒の露出で撮影され、DarkDiffの強化版は、300倍長い露出時間で三脚を使用して撮影された参照写真と比較されました。

ただし、AIベースの処理は従来の方法よりも大幅に遅く、携帯電話で実行する場合はバッテリー消耗が激しいため、クラウド処理が必要となる可能性があります。また、暗所での非英語テキスト認識に限界があるということです。

この研究がiPhoneにすぐに導入されるとは限りませんが、アップルが計算写真技術の進歩に注力していることを示しています。近年、スマートフォン市場全体でこの分野への関心が高まっており、顧客はデバイスの物理的な制約を超えるカメラ機能を求めています。