アップル社の研究チームは、画像の理解、生成、編集を単一のモデルで行うことができる「UniGen 1.5」を開発したと発表しました。これは、以前のモデル「UniGen」を基にしたもので、画像編集の能力を追加したものです。

昨年5月、アップルの研究チームは、「UniGen: 統一的なマルチモーダル理解と生成のための強化トレーニングとテスト戦略」という研究を発表しました。この研究では、画像の理解と生成を単一のシステムで行う統一的なマルチモーダル大規模言語モデルを紹介しました。

今回の「UniGen-1.5」では、画像編集の機能を追加し、理解、生成、編集を別々のシステムに分けることなく、単一の統一されたフレームワークで行うことを目指しています。これにより、モデルが理解能力を活用して生成性能を向上させることができるとしています。

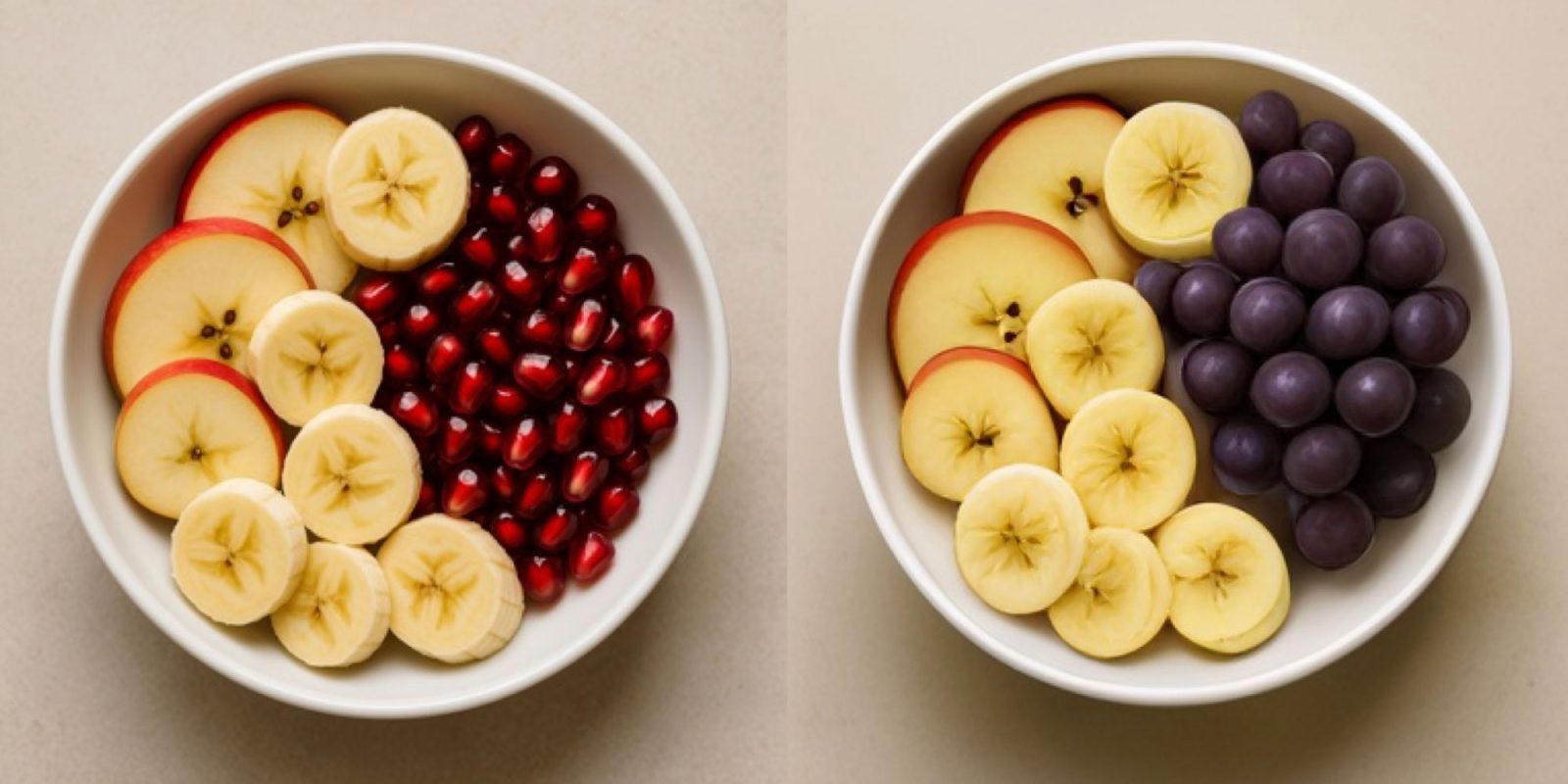

研究者によれば、画像編集における主な課題の一つは、モデルが複雑な編集指示を十分に理解できないことです。これに対処するため、「Edit Instruction Alignment」という新しいポストトレーニングステップを導入しました。

具体的には、条件画像と指示を入力として、テキスト記述を通じてターゲット画像の意味内容を予測することで、編集指示とターゲット画像の意味の整合性を高めることを目指しています。このステージは、編集性能を向上させる上で非常に有益であると実験結果が示しています。

さらに、強化学習を用いて、画像生成と編集の両方に同じ報酬システムを使用することで、これまで困難だった編集の範囲を統一的に処理することができるとしています。

この結果、業界標準のベンチマークテストで、UniGen-1.5は複数の最新のオープンおよびプロプライエタリなマルチモーダル大規模言語モデルを上回るか、同等の性能を示しました。

しかし、UniGen-1.5はテキスト生成や特定の状況下でのアイデンティティの一貫性に課題があるということです。失敗例として、テキスト生成時に文字の細かな構造を制御できない場合や、画像編集時にアイデンティティが変わる場合が挙げられています。

この研究の全文は、こちらからご覧いただけます。